Zatopione patio (sunken patio): Rewolucyjne rozwiązanie dla Twojego ogrodu

Czym jest zatopione patio i dlaczego warto je mieć?

Zatopione patio, znane również jako sunken patio lub patio wpuszczone w grunt, to designerskie rozwiązanie architektoniczne,...

Jak stylizować jeansy z szerokimi nogawkami (wide leg)?

Jeansy z szerokimi nogawkami, znane również jako jeansy wide leg, to jeden z najgorętszych trendów ostatnich sezonów. Choć na pierwszy rzut oka mogą wydawać...

Co zrobić ze starym autem, którego nie da się już naprawić?

Posiadanie samochodu, który odmówił posłuszeństwa i którego naprawa jest nieopłacalna, może stanowić niemały problem. Zamiast jednak pozostawiać go na złomowisku lub jako niepotrzebny balast,...

Model selection w świecie technologii: Kluczowe aspekty wyboru

Czym jest model selection i dlaczego jest tak istotne?

W dzisiejszym świecie technologii, gdzie innowacje pojawiają się w zawrotnym tempie, wybór odpowiedniego modelu stanowi fundament...

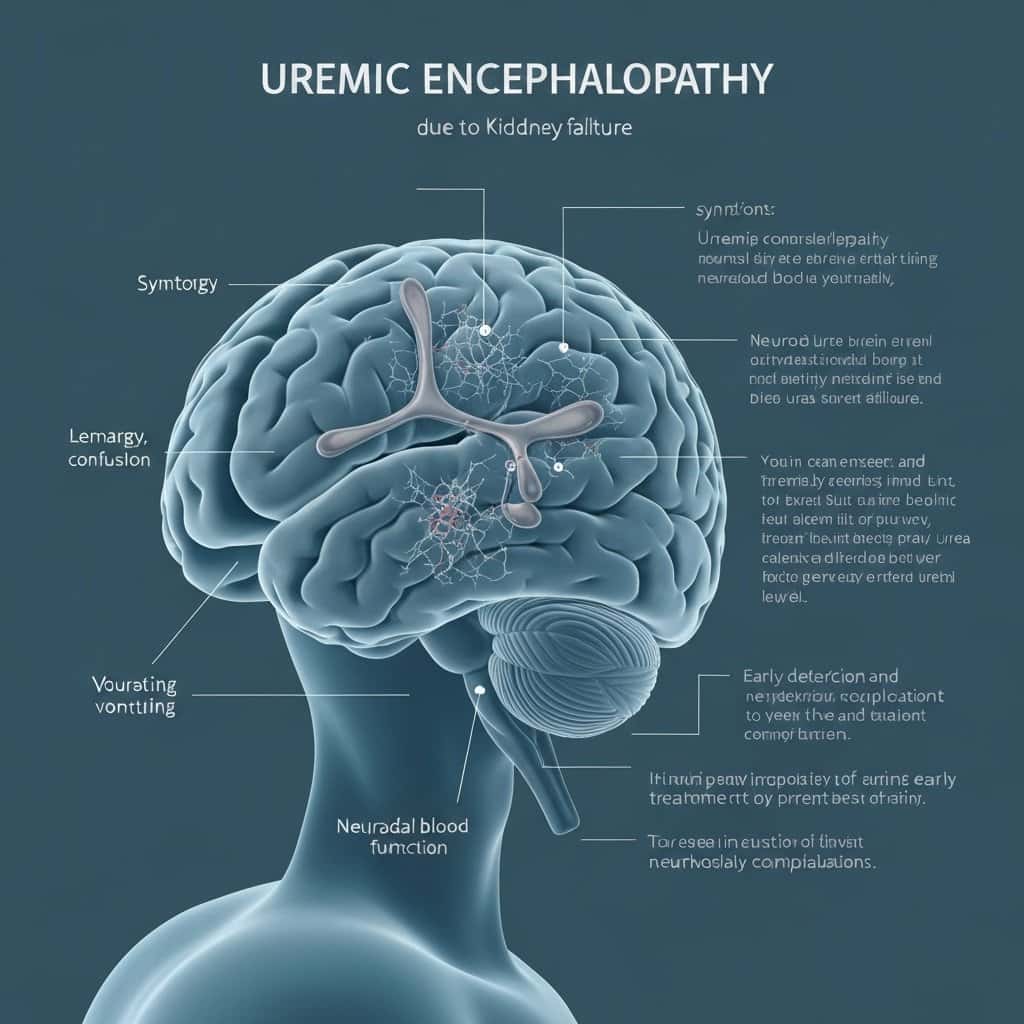

Encefalopatia uremiczna: Zrozumienie, objawy i leczenie

Encefalopatia uremiczna to poważne powikłanie przewlekłej choroby nerek, które dotyka funkcjonowania mózgu. Jest to stan neurologiczny wynikający z nagromadzenia toksyn mocznicowych we krwi, które...

Napięcia wokół Tajwanu: Zrozumienie złożonej sytuacji geopolitycznej

Wprowadzenie do kwestii tajwańskiej

Kwestia Tajwanu jest jednym z najbardziej zapalnych punktów na globalnej mapie politycznej. Tajwan, oficjalnie Republika Chińska (ROC), funkcjonuje jako samorządna demokracja,...

Informacja PIT-11 dla pracownika: Kompleksowy przewodnik

Czym jest PIT-11 i kto go wystawia?

PIT-11 to podstawowy dokument, który pracodawca (płatnik) przekazuje pracownikowi (podatnikowi) oraz urzędowi skarbowemu. Jego głównym celem jest poinformowanie...

Drewno z odzysku (reclaimed wood) – skąd pozyskać i jak przygotować?

Drewno z odzysku, znane również jako reclaimed wood, to materiał o niezwykłym charakterze i historii, który zyskuje coraz większą popularność w aranżacji wnętrz. Jego...

Jak zostać projektantem mody: Droga do świata designu

Kariera projektanta mody to marzenie wielu osób zafascynowanych światem stylu, tkanin i kreatywności. Choć ścieżka ta bywa wymagająca, odpowiednie przygotowanie, pasja i determinacja mogą...

Ford Escort – ikona motoryzacji i jej ewolucja

Ford Escort, niegdyś jeden z najpopularniejszych modeli w Europie i Ameryce Północnej, to samochód, który na stałe zapisał się w historii motoryzacji. Jego produkcja...